O uso de reconhecimento facial via inteligência artificial não é polêmico apenas quando se levantam dúvidas envolvendo privacidade: pesquisadores começam a se questionar se uma tecnologia usada para identificar pessoas remotamente sem que elas saibam, com potencial para controlar e criminalizar indivíduos, pode ser fundamentalmente perigosa.

O sinal de alerta veio em setembro de 2019, quando quatro pesquisadores pediram à Wiley, uma editora internacional que tem em seu catálogo milhares de livros e periódicos da área acadêmica, para "respeitosamente" retirar do ar um estudo de 2018 sobre o treinamento de algoritmos para distinguir rostos do povo uigur, uma etnia perseguida, vigiada e confinada a "campos de reeducação" pelo governo chinês (existem quase 140 estudos semelhantes revisados e publicados por outras editoras científicas, como Springer Nature e Elsevier).

Câmeras de vigilância em Xinjiang, China, onde o governo mantém "campos de reeducação" para a população uigur.Fonte: AFP/Greg Baker/Reprodução

Câmeras de vigilância em Xinjiang, China, onde o governo mantém "campos de reeducação" para a população uigur.Fonte: AFP/Greg Baker/Reprodução

Isso fez que cientistas questionassem a comunidade e apelassem por uma posição clara contra esse tipo de pesquisa, principalmente por conta da coleta, há tempos e sem consentimento, de enormes conjuntos de dados de imagens de rostos usados para aprimorar, em última instância, algoritmos de uso militar, policial e comercial.

Sem consentimento

A revista Nature fez uma pesquisa com 480 cientistas do mundo todo que trabalham com reconhecimento facial, visão computacional e inteligência artificial (IA). Cerca de 40% defenderam que é preciso obter o consentimento dos indivíduos antes de usar os rostos; 58%, porém, acharam que não é necessário.

"Muitos pesquisadores não querem ouvir sobre isso: eles consideram que não é problema deles", disse o especialista em biometria Sébastien Marcel, do Idiap Research Institute, cujo grupo usa bancos de rostos que outros compilaram.

Engenheira de software testa programa para identificar pessoas de máscara na empresa de tecnologia Hanwang, em Pequim.Fonte: Reuters/Thomas Peter

Engenheira de software testa programa para identificar pessoas de máscara na empresa de tecnologia Hanwang, em Pequim.Fonte: Reuters/Thomas Peter

Outra questão da Nature se referiu à pesquisa de reconhecimento facial de populações vulneráveis, como refugiados e grupos minoritários, perguntando se seria eticamente questionável mesmo se houvesse assentimento no uso das imagens. No geral, 71% disseram que sim, mas muitos observaram que o consentimento dado por esses indivíduos pode ser questionado, tornando-o potencialmente sem valor.

Ingenuidade

Os que discordaram usaram a distinção entre pesquisa acadêmica pura e uso prático do reconhecimento facial, dizendo que é preciso ter cuidado para não restringir a ciência ao condenar o uso da tecnologia. Para aqueles preocupados com a ética em IA, a distinção é ingênua: "Essa é a mentalidade de 'eu sou apenas um engenheiro'; já passamos disso", disse a socióloga especialista em ética da tecnologia Karen Levy, da Universidade Cornell.

Para os chamados eticistas, é preciso que o problema seja reconhecido: "A comunidade de IA não vê como seu trabalho se encaixa em uma longa história da ciência sendo usada para legitimar a violência contra pessoas marginalizadas, estratificando e separando seres humanos. Se você projeta um algoritmo de reconhecimento facial para pesquisa médica sem pensar em como ele poderia ser usado pela polícia, você está sendo negligente", explicou a pesquisadora do Instituto de Tecnologia de Massachusetts (MIT) Chelsea Barabas.

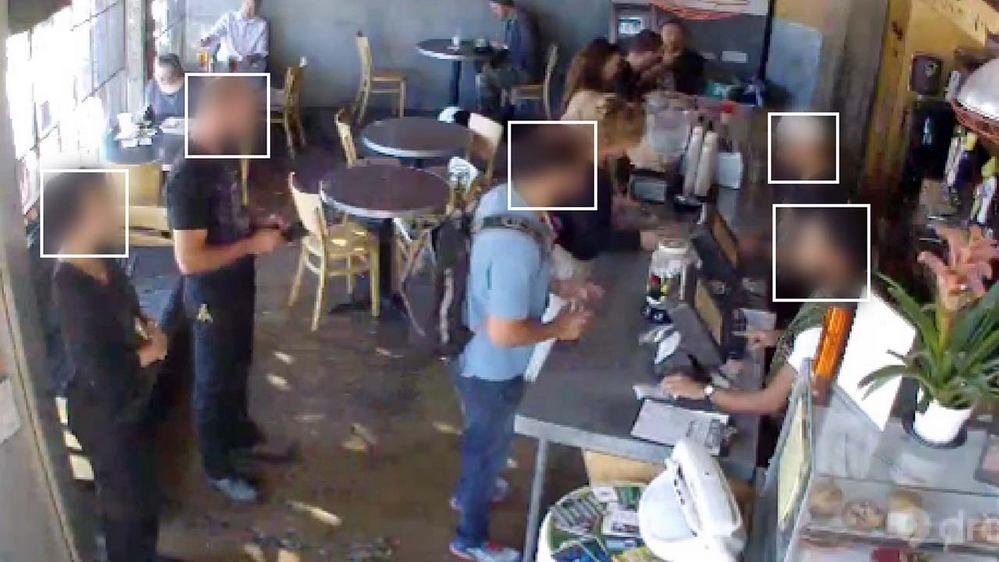

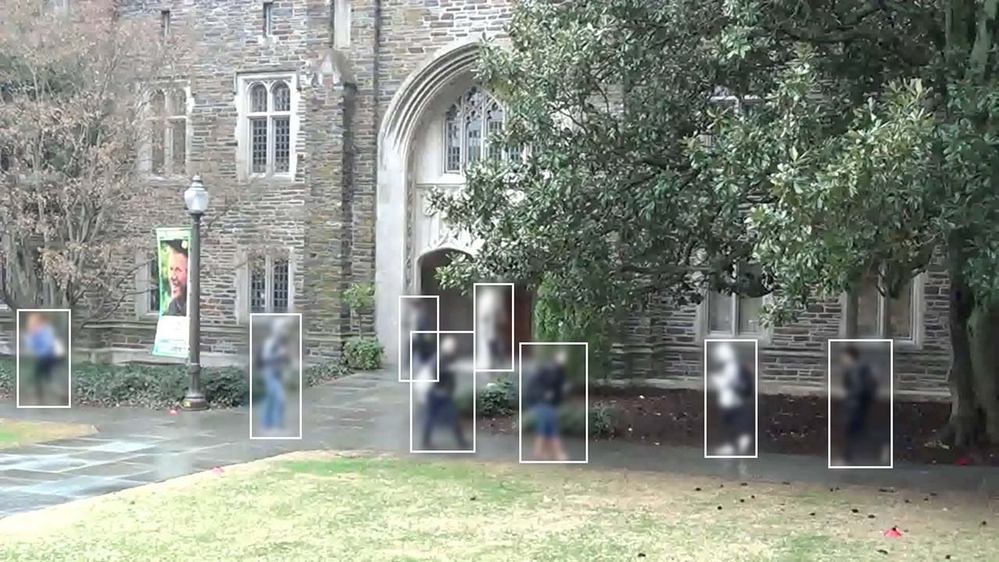

Como é preciso um grande número de rostos para treinar os algoritmos, a maioria dos pesquisadores coleta imagens sem permissão, e o problema só aumentou com o advento da internet e das redes sociais. Em 2015, cientistas da Universidade Stanford fizeram um banco de dados com 12 mil faces captadas por uma webcam em um café de São Francisco (EUA).

MegaPixels/Reprodução

MegaPixels/Reprodução Foram imitados, no ano seguinte, por colegas da Universidade Duke, que divulgaram, sem nenhum consentimento, mais de 85 minutos de imagens de alunos caminhando no campus.

MegaPixels/Reprodução

MegaPixels/Reprodução Ainda em 2016, pesquisadores da Universidade de Washington veicularam online o banco de dados MegaFace, uma coleção com 4.753.320 de rostos de 672.057 pessoas identificadas através de 3.311.471 de fotos baixadas de 48.383 álbuns de usuários do Flickr. Todas as fotos incluíam licenças Creative Commons, mas a maioria não foi licenciada para uso comercial.

MegaPixels/Reprodução

MegaPixels/Reprodução A marca acabou superada pelos cientistas da Microsoft Research e seu MSCeleb 5: 10 milhões de imagens, retiradas da internet, de quase 100 mil pessoas.

MegaPixels/Reprodução

MegaPixels/Reprodução Furto em redes sociais

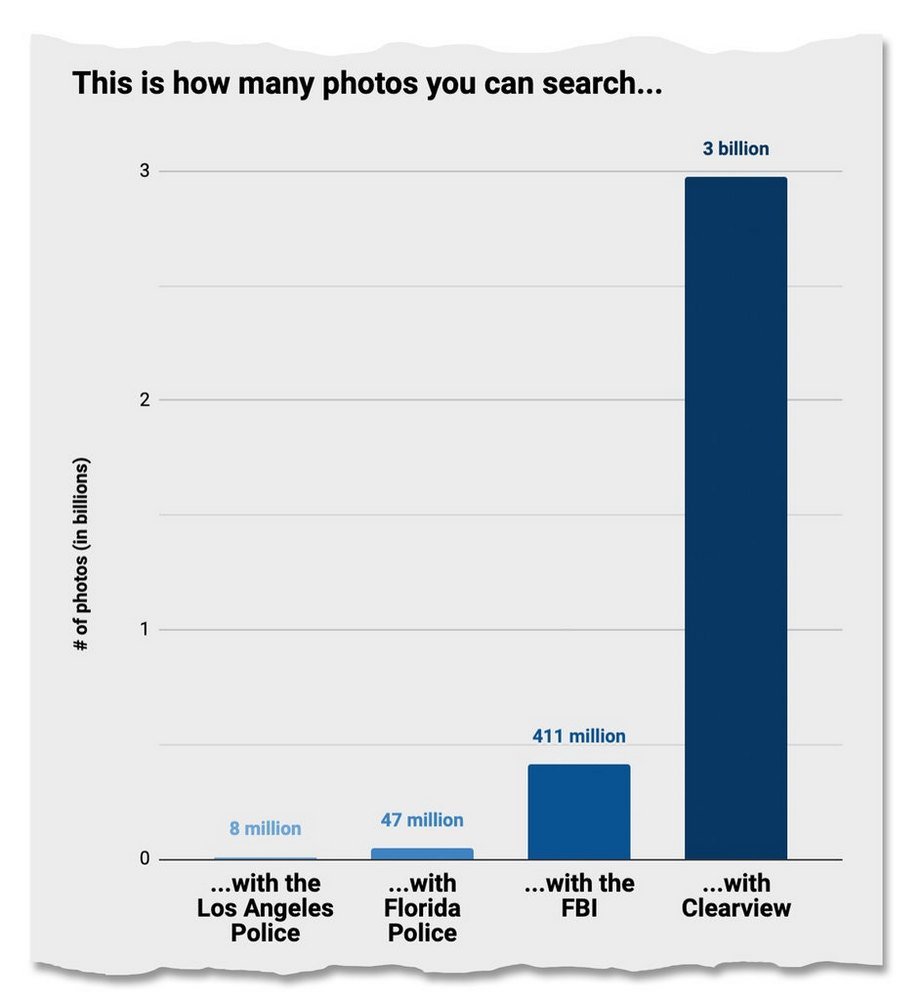

O caso mais escandaloso, porém, é o caso da empresa Clearview AI, cujo programa foi vendido a mais de 600 agências de aplicação da lei e departamentos de polícia nos Estados Unidos: 3 bilhões de imagens de pessoas, de todas as redes sociais (Facebook, Twitter, Instagram, YouTube, Vimeo, Flickr...) e milhões de outros sites foram baixadas e hoje compõem um gigantesco banco de dados. Com ele, é possível subir a foto de uma pessoa, e o programa responde onde ela aparece: links, vídeos, documentos, qualquer coisa que estiver online.

NYT/Reprodução

NYT/Reprodução Não há limites para como seu rosto (filmado, digitalizado e distribuído sem seu consentimento) vai ser usado. Ações judiciais já surgiram em tribunais nos EUA e na Europa: se o Facebook desembolsou US$ 650 milhões para pôr fim a uma ação coletiva contra o uso de rostos sem permissão, o Regulamento Geral de Proteção de Dados (GDPR) da União Europeia não prevê o que fazer com pesquisadores que coletam imagem para pesquisas biométricas sem conhecimento de ninguém que não eles mesmos.

Muitos conjuntos de dados reunidos para pesquisas foram retirados de circulação, mas os grandes bancos de dados, como o da Microsoft, continuam a ser usados por cientistas e enviados a outras instituições como derivados dos trabalhos.

Quanto ao estudo sobre a identificação da população uigur, a Wiley recusou o pedido para retirar a pesquisa do ar, afirmando que ela "poderia ser firmemente separada das ações que hoje ocorrem na China. Estamos cientes da perseguição às comunidades uigur. No entanto, esse artigo é sobre uma tecnologia específica, e não sobre sua aplicação".

![Imagem de: Home office: 65 vagas para trabalho remoto internacional [16/04]](https://tm.ibxk.com.br/2025/04/16/16164831199013.jpg?ims=288x165)