No dia a dia virtual, nos deparamos, constantemente, com ferramentas utilizadas por inteligência artificial capazes de categorizar, automaticamente, determinados conteúdos. Ao postar uma foto no Facebook, por exemplo, é bem comum que sugestões de marcações de amigos presentes na imagem sejam sugeridas. Ainda que auxiliando no treinamento dessas tecnologias, como quando respondemos captchas, sejamos capazes de supor a finalidade de alguns testes, aqueles que não entendemos recebem uma atenção especial de um público mal-intencionado: spammers e scammers.

Geralmente, quem busca driblar banimentos e denúncias por conteúdos abusivos se dedica a entender o funcionamento da inteligência artificial para se esquivar de detecção. Nesse processo, trabalho humano é um diferencial, mas não dá conta do recado. Além de ter de enfrentar o desenvolvimento constante de novas técnicas que não alertam o comportamento inadequado às máquinas, uma rede social como o Facebook lida com bilhões de contas ativas todos os meses.

Tecnologia, negócios e comportamento sob um olhar crítico.

Assine já o The BRIEF, a newsletter diária que te deixa por dentro de tudo

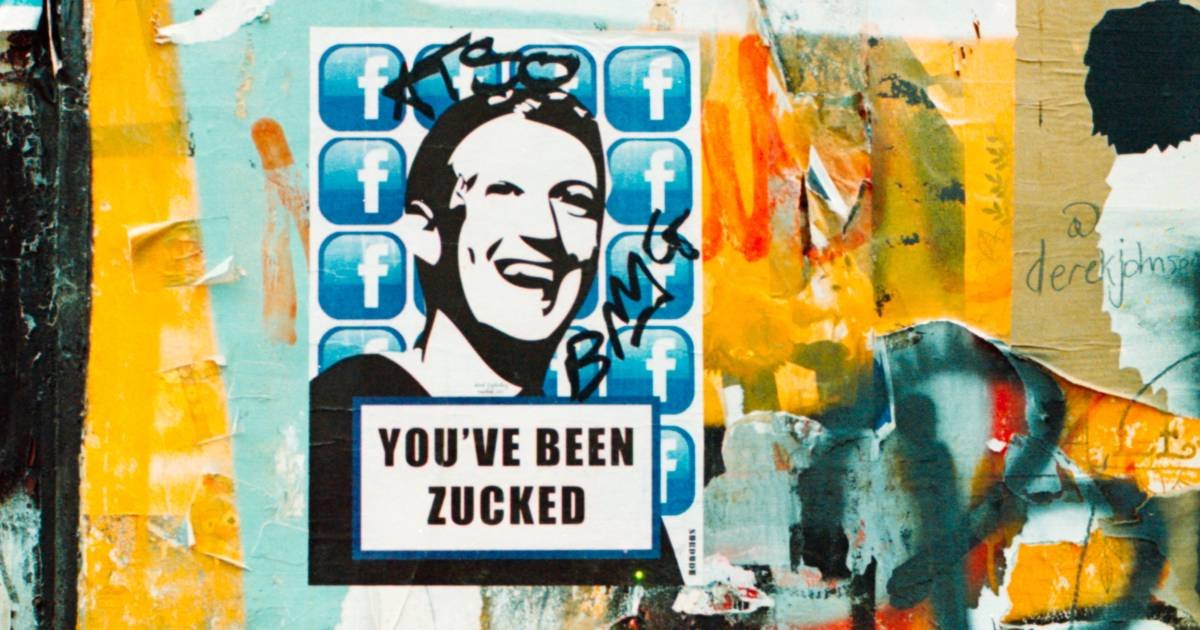

Não à toa, a plataforma criada por Zuckerberg é a mais interessada em combater aqueles que infrinjam as poíticas de uso – e parece ter encontrado uma resposta para o problema. Em anúncio à imprensa, a empresa divulgou um jeito de tornar a inteligência artificial cada vez mais eficaz e que pode ser aplicado em tarefas que vão muito além de sua timeline.

Dados e mais dados

Devido à quantidade massiva de conteúdo, apenas uma pequena parte dos comportamentos que violam os termos de uso é identificada atualmente. Para desenvolver uma maneira de evitar uma verdadeira enxurrada de spams, por exemplo, dados que podem ser utilizados por um sistema automático e por algoritmos dedicados à supervisão são fundamentais, e eles são coletados com base no seu comportamento na internet.

Se você concordou com os termos de uso mesmo sem ler, cedeu automáticamente tais informações. Entretanto, aqueles que gerenciam contas abusivas também têm acesso aos termos de uso e são especialistas em "prever" como se esconder. Foi aí que os pesquisadores do Facebook pensaram em uma solução: o uso de metadados.

A técnica de é relativamente simples. Em vez de simplesmente analisar o conteúdo postado por você, o sistema vai analisar, também, aquilo que suas conexões postam, assim como as conexões de suas conexões, criando a chamada "Deep Entity" (a Grande Entidade), um perfil resultante de uma série de valores combinados.

Sabe aquela história de que "a fruta não cai longe do pé"? Contas idôneas, geralmente, se relacionam com outras contas idôneas. Spammers e scammers se relacionam com spammers e scammers. Mudar esse comportamento é muito mais trabalhoso, e a dificuldade de entender como a inteligência artificial pode classificar uma conta é muito mais alta. Um ponto a mais para o time de contenção.

Da teoria à pratica

Uma rede neural é responsável pela análise dos perfis, que classifica automaticamente quais apresentam problemas e quais não. Depois disso, antes dos metadados, havia duas opções: utilizar outros algortimos classificatórios, responsáveis pela geração de uma grande quantidade de dados conflitantes, ou moderação humana, que, apesar da eficácia, é muito mais lenta. Naturalmente, o time de pesquisadores da rede social aliou as alternativas, se dedicando tanto ao uso automatizado quanto à expansão da equipe de moderadores.

A diferença, agora, é que a autonomia da inteligência artificial foi expandida por meio das chamadas árvores de decisões, uma técnica de machine learning. Basicamente, se antes havia duas camadas de análise, a de processamento para chegar a uma decisão binária e a de classificação final da conta, a rede neural, por meio das informações coletadas e treinamento dedicado, é capaz de realizar a análise e tomar a decisão para a qual foi programada. Havendo várias árvores de decisão, há múltiplas possibilidades de resposta, não apenas um "Problemático" ou "Não problemático" superficial e genérico.

Os resultados da inovação são promissores: pelo menos meio bilhão de contas foram bloqueadas por trimestre, atingindo mais de 2 bilhões de perfis no primeiro período do ano passado. Naturalmente, o sistema vai sendo aprimorado com o uso, mas aí surge a questão: quem vigia os vigilantes?

Conflito ético no uso da inteligência artificial

Ainda que o uso de metadados seja altamente eficiente, é preciso refletir sobre sua aplicação em grande escala. Afinal, é justo que contas possam ser suspensas sem que denúncias sejam realizadas? Enquanto equipes humanas se dedicam a uma análise acurada de um comportamento reportado, a autonomia da inteligência artificial permite que ela aja preventivamente. Se as conexões mais próximas criam um cenário inadequado, o perfil em questão é colocado no mesmo pacote sem chance de defesa.

Além disso, como prevenir que uma ferramenta tão potente se torne uma espécie de "dona da verdade" e seja utilizada de maneira arbitrária para classificar o conteúdo analisado como pertinente ou não, minando possibilidades de debate de diferentes pontos de vista?

É fato que a internet já não parece tão livre quanto acreditávamos ser antigamente. Com o desenvolvimento dos metadados e o avanço da inteligência artificial, entretanto, enquanto vamos postando a foto do churrasco do fim de semana e curtindo os memes dos amigos, só nos resta acompanhar até onde o controle da informação, restrito a poucas organizações, vai chegar.