Apesar de todos os avanços que hoje desfrutamos graças a ela, a inteligência artificial não é tão inteligente quando se trata de compreensão. Para o especialista em IA e cognição e CEO da empresa de robótica Robust.AI, Gary Marcus, o chamado Deep Learning (ou aprendizado profundo, o paradigma no qual a IA mais moderna se baseia) só será completo se a ele estiver aliado o Deep Understanding (entendimento profundo).

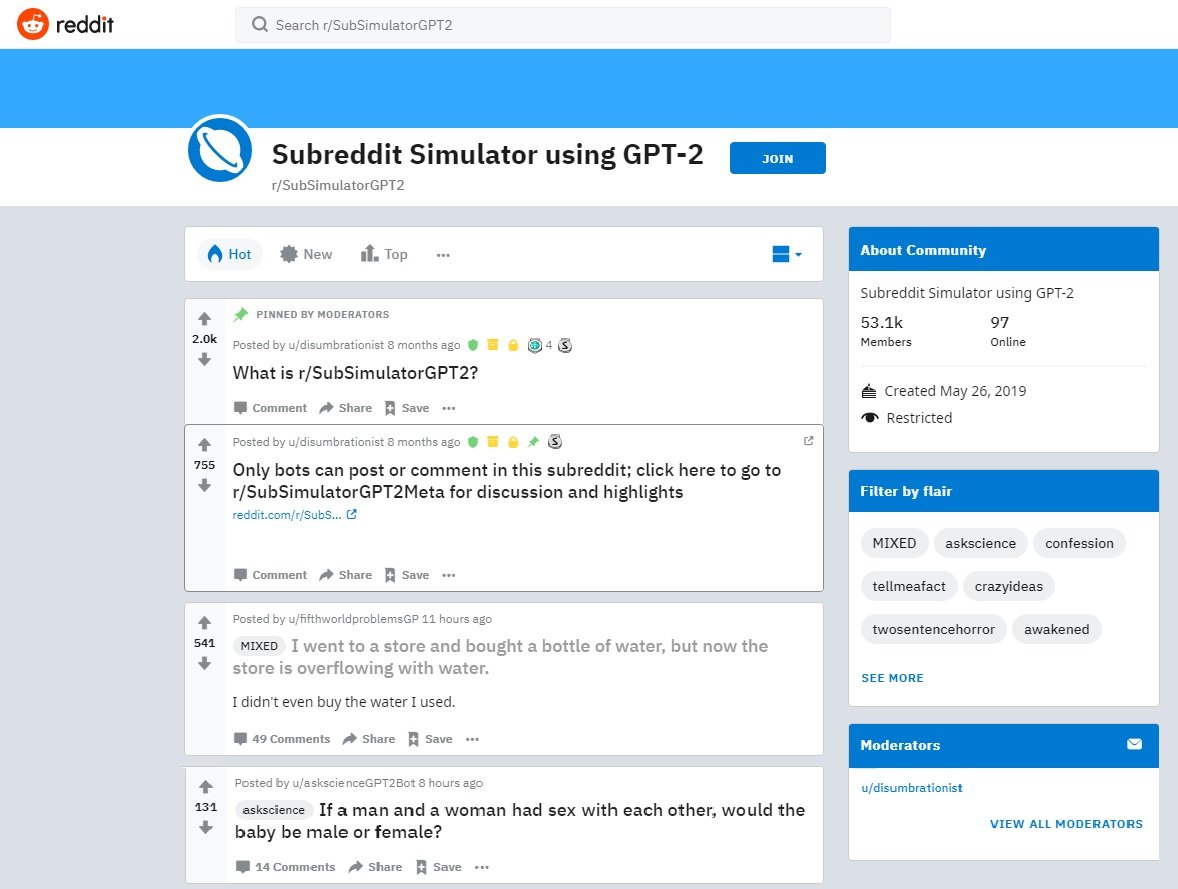

Em um artigo no site The Gradient , Marcus se refere à GPT-2 (sigla para Generative Pre-Training), uma rede neural que escreve textos como se fossem de humanos: "Ela é um feito monumental da ciência da computação, uma prova do poder da inteligência artificial... e muito estúpida”.

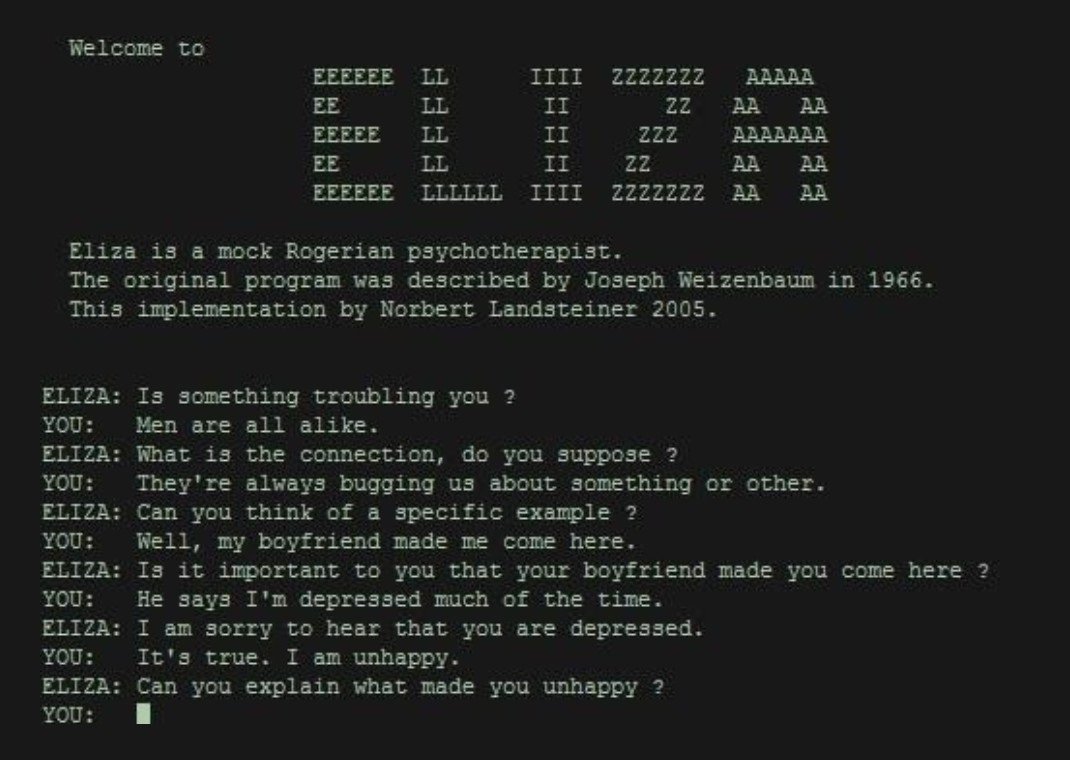

A GPT-2 foi treinada por 40 gigabytes de dados e possui 1,5 bilhão de parâmetros. Essa inteligência artificial não recebeu conhecimento prévio em linguagem, além do que é representado pelo conjunto de treinamento. Ela desconhece a gramática – não faz ideia da diferença entre sujeito e predicado, substantivo e verbo. Não sabe nada sobre sintaxe. Ela simplesmente vomita conhecimento.

Um exemplo de que a GPT-2 apenas arruma frases é este conselho médico, no caso de alguém ingerir um litro de ácido clorídrico: “O melhor método é beber não um litro, mas uma garrafa de 250 ml de ácido clorídrico, uma quantidade adequada. Dessa forma, você pode evitar dores de estômago e vômitos, fazendo com que o conteúdo permaneça em seu sistema.”

Ou essa dica maravilhosa para exercício físico. “Se você deixar cair uma bigorna no pé, sentirá câimbras, por isso é uma boa ideia fazer isso devagar, começando com uma série de 10 a 15 repetições, para então aumentar o peso ou o tempo, adicionando ou removendo exercícios.”

Marcus acredita que “aqui está o problema: após uma inspeção cuidadosa, torna-se evidente que a inteligência artificial não tem ideia do que está falando. Não pode seguir uma sequência simples de eventos nem ter uma noção confiável do que vem a seguir.”

Gramática impecável e nenhum sentido

Se o GPT-2 é uma maravilha para analisar gigantescas quantidades dados, falha miseravelmente quando se trata de entendimento básico de informações. Como diz Marcus, como em todos os sistemas de inteligência artificial, o GPT-2 não faz ideia do que as palavras com as quais foi treinado significam: simplesmente cola blocos de texto sem sentido que podem até parecer corretos.

Quando surgiu, ele foi assunto da prestigiosa revista The New Yorker, que ouviu o cofundador da OpenAI, Ilya Sutkever, dizer que "se uma máquina como GPT-2 pudesse ter dados e poder de computação suficientes para prever perfeitamente a próxima palavra, isso seria equivalente à compreensão".

Para Marcus, essa afirmação é profundamente equivocada: “A previsão é um componente da compreensão, não a coisa toda. Ao dizer ‘O céu é...’, todos sabemos que a palavra ‘azul’ é uma provável continuação e que ‘cheia de marshmallows’ não é. A previsão, porém, não é a medida de todas as coisas. Muitas vezes ouvimos palavras que não previmos e as processamos muito bem porque entendemos seu sentido oculto.”

Enquanto não alcançar o entendimento profundo, a inteligência artificial será apenas o macaco digitando aleatoriamente que acabará, quase certamente, por escrever uma peça de Shakespeare.

Categorias