Quando se trata de músicas, vídeos, textos e discursos, o maior desafio para a Inteligência Artificial é compreender o contexto que está sendo apresentado. Por exemplo, se durante um vídeo uma pessoa desaparecer e retornar posteriormente, muitos modelos vão esquecer que ela já esteve lá.

A Google enfrentou esse problema com o Transformer, uma rede neural que compara palavras em um mesmo parágrafo para entender a relação entre elas. Esse modelo é capaz de compreender textos de até mil palavras, sintetizá-los e traduzir frases inteiras. Apesar disso, quando a compreensão de um texto, vídeo ou imagem depende de um contexto mais complexo… As capacidades do Transformer não são suficientes.

Para corrigir esse erro, a Google lançou o Reformer, um modelo aprimorado que supre as deficiências do seu irmão mais novo. Com ele é possível criar artigos inteiros para Wikipedia através da síntese de múltiplos textos, isso porque Reformer tem a capacidade de compreender até um milhão de palavras — e com apenas 16GB de memória.

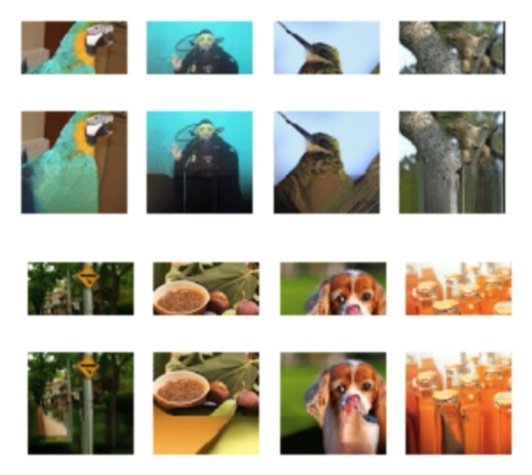

Utilizando hash sensível à localidade (LSH), técnica algorítmica da Ciência da Computação, o modelo consegue unir palavras semelhantes próximas (não somente no mesmo parágrafo) e fazer comparações maiores e mais rápidas. Essa habilidade impede que ele se perca em frases longas e contextos muito complexos. Além disso, ele também consegue completar imagens "cortadas", como é possível observar na foto acima.

Engenheiros da Google afirmam que o Reformer consegue facilmente compreender livros inteiros, demonstrando um enorme potencial para processar textos em massa. O que achou dessa novidade? Dê sua opinião nos comentários!

Categorias

![Imagem de: Home office: 65 vagas para trabalho remoto internacional [16/04]](https://tm.ibxk.com.br/2025/04/16/16164831199013.jpg?ims=288x165)