O uso do aprendizado de máquina e do aprendizado profundo da inteligência artificial (IA) tem levado a criação de imagens, gráficos e vídeos a um outro patamar. Com o desenvolvimento desses setores, é possível treinar algoritmos para que eles gerem mundos virtuais em tempo real, o que pode ser muito interessante para o setor de game, por exemplo — assim, dá para conceber mapas inteiros de um jogo aberto na hora, sem a necessidade de renderização ou desenho prévio.

Inteligência artificial usa referências para “montar os cenários ao vivo”

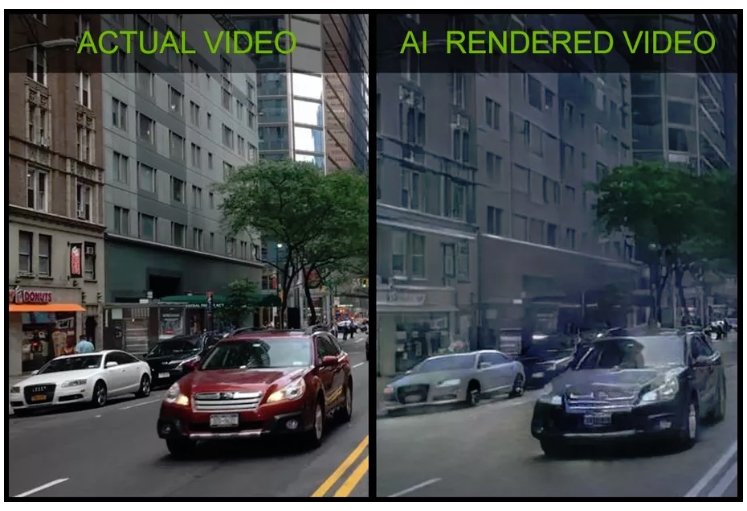

E é justamente isso que a Nvidia acaba de apresentar, uma pesquisa que une visual criado por IA em um tradicional motor de videogames, resultando em um sistema de gráficos híbridos, que pode ser usado na indústria do setor de entretenimento digital, inclusive filmes e realidade virtual. "É uma nova maneira de renderizar conteúdo de vídeo usando o aprendizado profundo. Obviamente, a Nvidia se preocupa muito com a geração de gráficos e estamos pensando em como a IA vai revolucionar o campo”, disse Bryan Catanzaro, em entrevista ao The Verge.

Os engenheiros da empresa explicam que se basearam em vários métodos existentes, como o sistema de código aberto chamado pix2pix. Seus trabalhos implantam um tipo de rede neural conhecida como rede adversária generativa (generative adversarial network ou GAN. Ambos, são amplamente utilizado na geração de imagens de IA.

Um simulador de direção mostra como os participantes podem trafegar pelos quarteirões de ruas montadas pela IA com uma única placa de vídeo, a Titan V, a mais poderosa da empresa até o momento.

Como os engenheiros chegaram a esses resultados?

Primeiro, os pesquisadores precisam coletar dados para o treinamento dos algoritmos. Neste caso, foram obtidos de conjuntos de dados de código aberto usados para o desenvolvimento de direção autônoma. A filmagem é então segmentada, o que significa que cada quadro é dividido em diferentes categorias: céu, carros, árvores, estradas, edifícios e assim por diante.

Modelo da pesquisa uso como base o motor gráfico Unreal Engine 4, usado em games como Fortnite e Gears of Wars

Uma rede é então aprimorada com essas informações para gerar novas versões desses objetos. Em seguida, os engenheiros criaram a topologia básica do ambiente virtual usando um mecanismo de jogo tradicional. No exemplo, o motor usado foi o Unreal Engine 4, usado em títulos populares, a exemplo de Fortnite, PUBG, Gears of War 4, entre outros.

Usando esse ambiente como estrutura, os algoritmos de aprendizagem profunda geram os gráficos dos diferentes elementos em tempo real, “colando-os” nos modelos presentes no game. “A estrutura do mundo está sendo criada tradicionalmente. A única coisa que a IA gera são os gráficos”, diz Catanzaro. Um dos problemas superado nesse estudo foi manter um objeto parecendo o mesmo por algum tempo, caso contrário os itens ficariam mudando de cor ou de formato a cada frame por segundo. Para solucionar isso, a Nvidia usa uma memória curta que compara os itens antes de substituí-los.

Fonte: Nvidia

Fonte: Nvidia

Essa tecnologia ainda está nos estágios iniciais e deve ampliar a discussão sobre a criação de deep fakes. Mas, com os belos resultados obtidos até agora, é bem possível que ela esteja presente nos games da próxima geração de consoles — ou até na atual — e em vários outros sistemas, seja em carros autônomos ou de realidade virtual e etc.

Fontes

Categorias