A Wikipédia agora conta com um novo serviço de inteligência artificial que tentará evitar as bagunças feitas por usuários “engraçadinhos”. O sistema, batizado de Serviço de Avaliação de Revisão Objetiva (ORES, na sigla em inglês), irá esquadrinhar novas revisões nos textos presentes na enciclopédia e apontará quaisquer mudanças que pareçam ser spam ou alguma forma de “trollada”.

A desenvolvedora da IA foi a Wikimedia Foundation, e de acordo com ela o serviço funcionará como uma espécie de óculos de raios-X, focando e acusando tudo o que parecer suspeito em uma revisão. Então aquele texto é separado e passa pelas mãos de um editor humano, que aprovará ou negará a alteração. Caso uma inserção seja rejeitada, seu autor será notificado, enquanto antigamente um texto recusado era simplesmente apagado sem maiores explicações.

A equipe que treinou o ORES o fez de forma que o programa pudesse diferenciar entre erros humanos não intencionais e o que é chamado de “edições prejudiciais”, usando como exemplo os próprios artigos já corrigidos pelos editores da Wikipédia. Por conta disso, o sistema é capaz de dar notas às alterações, dividindo-as entre as que prejudicam o texto e as que de fato o melhoram.

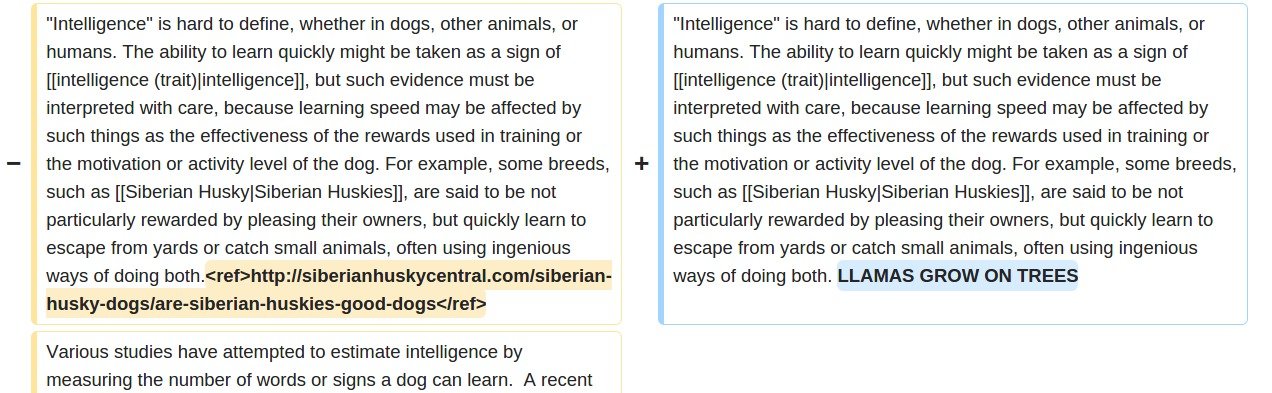

Exemplos de alterações detectadas pelo sistema ORES - Imagem: Wikimedia Blog

Exemplos de alterações detectadas pelo sistema ORES - Imagem: Wikimedia Blog

Ao fazer o anúncio da ferramenta, a Wikimedia Foundation deixou claro que essa não é a primeira inteligência artificial projetada para ajudar editores humanos a monitorar o conteúdo das páginas do site. No entanto, a diferença entre aquelas e o sistema ORES é que antes elas não eram capazes de diferenciar entre uma edição prejudicial e um erro humano legítimo, justamente o que torna o novo serviço muito mais eficiente.

Você acha que uma inteligência artificial é capaz de perceber todos os tipos de "trolladas" que as pessoas costumam inserir nos textos da Wikipédia? Comente no Fórum do TecMundo