Evolução tecnológica sempre foi a palavra de ordem para todos os setores da indústria, mas poucas áreas levam isso tão a sério quanto a informática. Afinal, trata-se de um mercado altamente lucrativo e, acima de tudo, extremamente competitivo.

A maioria dos componentes encontrados no computador tem acompanhado essa evolução com um ritmo parecido, mas existe um deles que, despercebidamente, acabou ficando para trás em relação aos outros: o disco rígido. Continue acompanhando esta matéria do Tecmundo e descubra o porquê dos HDs serem mais ultrapassados do que você imagina.

O longo caminho até o estado atual

O conceito de discos rígidos como conhecemos hoje apareceu inicialmente em 1956, depois de uma série de pesquisas e padronizações lideradas pela IBM. O objetivo era suprir o mercado de supercomputadores e mainframes com uma solução de armazenamento de dados que fosse mais confiável do que os disquetes flexíveis.

Como os HDs eram nos anos 50 e 60 (Fonte da imagem: Reprodução/PC World)

Como os HDs eram nos anos 50 e 60 (Fonte da imagem: Reprodução/PC World)

Porém, a tecnologia só chegou a ficar acessível para o mercado de microcomputadores pessoais na década de 1980. Para a época, o salto tecnológico oferecido pelos discos rígidos era enorme, já que as pessoas não precisariam mais carregar o sistema operacional a partir de um disquete ou ficar trocando de mídia à medida que outros aplicativos e arquivos precisassem ser carregados para a memória RAM.

Do início dos anos 80 até o final da década de 90, os avanços nos discos rígidos foram enormes. Os primeiros deles eram blocos que pesavam quatro quilos, podiam armazenar algumas dezenas de megabytes (mega, não giga) e custavam milhares de dólares. Discos de interface IDE e com o formato de 3,5 polegadas como conhecemos hoje já estavam amplamente difundidos no final dos anos 90, a maioria com mais de 2 GB e custando menos de U$ 100.

Evolução no tamanho físico dos HDs (Fonte da imagem: Divulgação Wikipedia)

Evolução no tamanho físico dos HDs (Fonte da imagem: Divulgação Wikipedia)

A evolução no tamanho físico do HDs e na densidade de dados que eles podem armazenar foi notável. Mas, como você pode perceber na imagem acima, a arquitetura básica de funcionamento permaneceu praticamente a mesma: um ou mais discos com milhões de clusters que podem ter sua polaridade invertida por uma cabeça magnética.

Limitações físicas

Desde a adoção dos formatos de 3,5 e 2,5 polegadas usados na maioria dos desktops e laptops de hoje, fabricantes entraram em uma corrida desenfreada para conseguir colocar o máximo de bits no mesmo espaço. Tecnologias como a gravação perpendicular e múltiplas cabeças de gravação contribuíram nesse aspecto, chegando aos HDs com mais de 1 terabyte disponíveis atualmente.

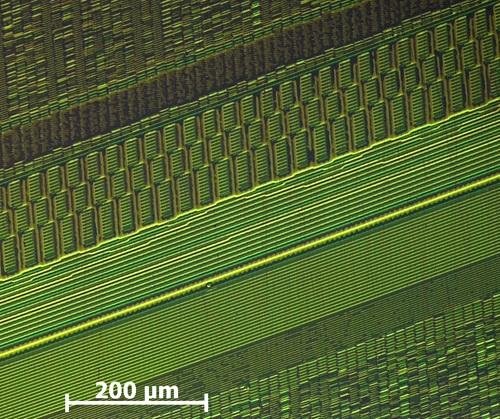

Imagem de um disco ampliada à escala nanométrica (Fonte da imagem: Divulgação/Wikimedia Commons)

Imagem de um disco ampliada à escala nanométrica (Fonte da imagem: Divulgação/Wikimedia Commons)

Porém, discos rígidos ainda dependem de uma série de partes mecânicas para operar e, assim como qualquer outro mecanismo de metal, todos estão fadados a deixar de funcionar algum dia por causa do desgaste das peças. As várias partes móveis também são a principal causa da alta fragilidade dos discos, além de contribuírem para o ruído.

Da mesma forma que acontece com as CPUs, a densidade máxima de bits por polegada também está perto do limite físico, impossibilitando que cada cluster fique ainda menor do que já é. Por isso, não espere unidades muito maiores do que os 3 TB usando-se apenas a tecnologia disponível na atualidade.

Velocidade de transferência

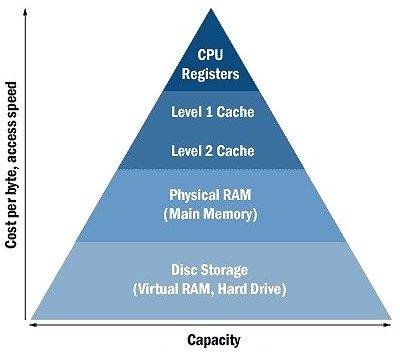

Outro problema difícil de ser resolvido é a velocidade com que os dados são lidos e escritos do e para o HD. Como muitos já sabem, o gargalo que limita o desempenho com que as tarefas são executadas pelo computador está quase sempre no disco rígido, já que ele é muito mais lento do que a memória RAM e uma verdadeira tartaruga se comparado com os registradores e a memória cache dentro do CPU.

Relação entre velocidade, custo e capacidade dos tipos de memória (Fonte da imagem: Reprodução/Real Knowledge)

Relação entre velocidade, custo e capacidade dos tipos de memória (Fonte da imagem: Reprodução/Real Knowledge)

A velocidade de transferência dos HDs até foi amplamente beneficiada depois que a interface passou da paralela (IDE) para a serial ATA, ou SATA, mas não há muitas perspectivas de crescimento enquanto a operação final ainda depender de uma agulha magnética esperando um disco chegar até a posição correta.

Tendências de evolução

A primeira grande novidade que todos acreditam ser a salvação para os discos rígidos é o SSD, ou “Solid State Drives”. Estes dispositivos de armazenamento em massa deixam de lado os discos magnéticos para passar a usar memórias flash, algo parecido com os cartões usados em dispositivos portáteis.

Como todas as partes móveis foram inteiramente substituídas por circuitos, a velocidade de transferência de dados passa dos usuais 125 MB por segundo — praticada pela maioria dos HDs — para 285 MB/s. A melhora prática desta diferença é notável, sendo que o sistema operacional pode ser iniciado na metade do tempo, bem como todos os demais programas que precisam ser carregados na memória RAM.

(Fonte da imagem: Divulgação/SanDisk)

(Fonte da imagem: Divulgação/SanDisk)

Porém, o alto preço cobrado pelos SSDs ainda os torna uma solução cara demais, sendo que é difícil de encontrar unidades com mais de 60 GB custando menos que R$ 350 no Brasil. Já unidades com mais de 500 GB, tamanho considerado mínimo para a maioria dos HDs modernos, passam facilmente dos mil reais.

Para contornar o problema do alto preço, fabricantes como a Seagate têm optado por soluções híbridas. Este tipo de dispositivo usa tanto memória flash quanto um disco rígido na mesma unidade. Desta forma, arquivos mais críticos, como os do sistema operacional, são armazenados na memória mais rápida, enquanto que os dados menos acessados ficam no disco mais lento.

SSD híbrido (Fonte da imagem: Divulgação/Seagate)

SSD híbrido (Fonte da imagem: Divulgação/Seagate)

Para aumentar ainda mais a velocidade de transferência, alguns fabricantes tem até deixado a interface SATA de lado para usar a PCI Express de 4X. Dessa forma, a taxa de transferência de dados pode saltar dos 285 MB/s para impressionantes 540 megabytes por segundo.

SSD com interface PCI Express 4X (Fonte da imagem: Divulgação/OCZ)

SSD com interface PCI Express 4X (Fonte da imagem: Divulgação/OCZ)

Note também que, com os leitores ópticos caindo cada vez mais em desuso, o HD é o último componente “grande” que ainda precisa ficar nas baias da parte da frente dos desktops. Já os SSDs que usam a interface PCI Express ficam posicionados diretamente sobre a placa mãe, um bom motivo para diminuir muito o tamanho dos gabinetes ATX usados hoje.

Outras alternativas

Com a intenção de contornar a limitação física do 1,5 terabyte por polegada quadrada, vários fabricantes têm trabalhado em novas tecnologias de gravação que continuam a usar os discos rígidos. Uma delas se chama “Heat-assisted Magnetic Recording” (HAMR) e está sendo liderada pela Seagate, com a proposta de deixar o método de gravação perpendicular obsoleto.

Protótipo do cubo holográfico (Fonte da imagem: Keol)

Protótipo do cubo holográfico (Fonte da imagem: Keol)

Outra pesquisa liderada pela Universidade de Nottingham estuda a possibilidade de se usar urânio desativado como material dos discos, já que a alta densidade do metal pode ser uma vantagem para a composição dos clusters que armazenam os “zeros e uns”. Mesmo que impressionantes, essas tecnologias têm como propósito apenas aumentar a densidade de armazenamento, sem muitas melhorias nos outros quesitos.

Já conceitos como o armazenamento em DNA ou mesmo os cubos holográficos podem revolucionar completamente a forma como guardamos e acessamos nossos arquivos em mídias digitais. Porém, cientistas e engenheiros estimam que ainda possa levar alguns bons anos antes que estas inovações se tornem realidade em nosso cotidiano.

Categorias