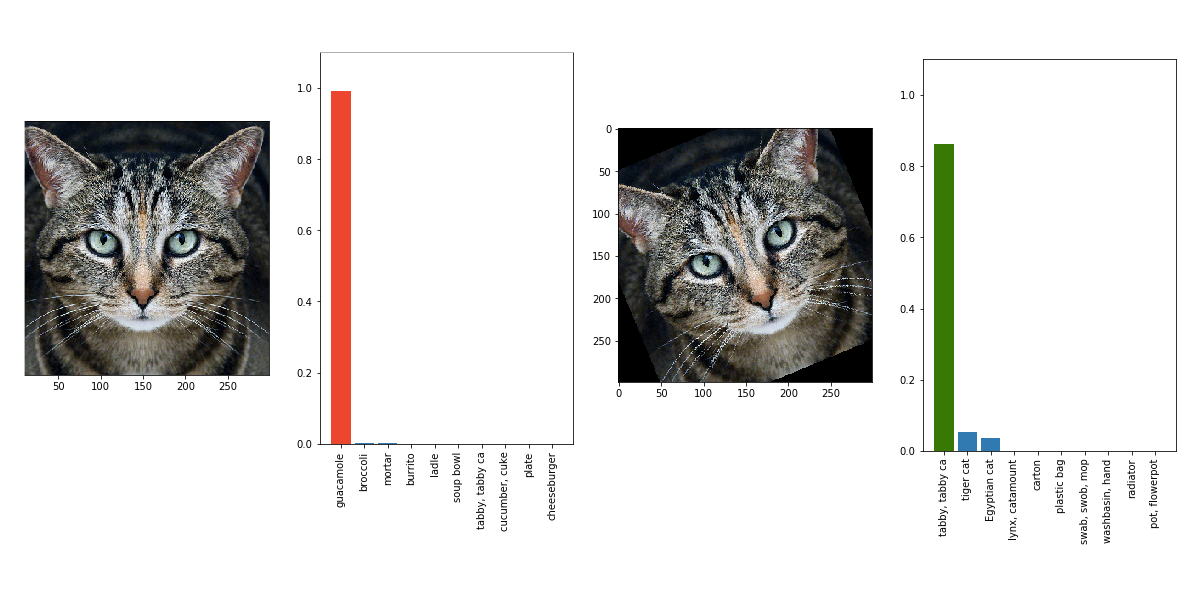

A inteligência artificial da Google está sendo preparada para ser usada em diversas finalidades diferentes, entre identificar objetos enquanto dirige um carro ou para auxiliar na identificação de objetos em imagens – e é nessa última parte que a tecnologia precisa de um pequenino ajuste.

Isso porque, de acordo com uma imagem divulgada pelo Labsix, um grupo de estudantes do MIT, a rede neural da gigante de tecnologia está confundindo alguns objetos. Um dos exemplos usados para ilustrar isso é do sistema identificando uma tartaruga feita com a ajuda de uma impressora 3D como se fosse... Um rifle?

Geralmente objetos assim são utilizados para testar a tecnologia, visto que ela incorpora alguns padrões que são colocados de forma intencional para enganar a IA, mesmo que algumas coisas sejam imperceptíveis aos olhos humanos.

A proteção contra esse tipo de interferência é uma das informações essenciais pra garantir que esse tipo de tecnologia seja aplicado com segurança no futuro e evitar situações como, por exemplo, criar uma forma de as câmeras de carros autônomos só vejam placas de pare.

Boa parte do problema pode ser resolvido de forma relativamente simples: basta girar ou mudar o ângulo para a IA identifique melhor os objetos. No caso do estudo desenvolvido pelo Labsix, no entanto, os padrões usados fazem com que o sistema se confunda em absolutamente todos os ângulos.

O Labsix vem chamando o método de pesquisa de “Expectativa sobre transformação”, com diversos testes usando itens impressos em 3D feitos para enganar as IAs por aí, especificamente a Inception-v3 da Google.

O estudo pode ser lido na íntegra e mostra que a inteligência artificial precisa ficar um pouquinho mais esperta antes de se tornar parte da rotina.

Fontes

Categorias