Se você é um entusiasta de computadores certamente já deve ter aberto o seu desktop para ver como as peças são dentro dele. Ou quem sabe você já montou o seu próprio computador? Somente quem já fez isso sabe como é o gosto de ligar o “Frankenstein” pela primeira vez e ver que tudo está funcionando direitinho.

Mas há alguns anos atrás isso não era uma tarefa muito simples. Hoje em dia dificilmente um computador não vá funcionar direito depois de montado, pois todos os componentes são bem compatíveis uns com os outros. Basta um pouco de cuidado — e bom senso — para manusear as placas e em poucos minutos tudo estará funcionando.

Mas isso não foi sempre assim. Há pouco mais de uma década montar um computador era uma tarefa que exigia um bom conhecimento profissional. Saber como combinar os componentes, regular, ajustar e configurar as máquinas podia ser uma verdadeira dor de cabeça para os marinheiros de primeiras viagem.

Processador

Instalar um processador hoje em dia é incrivelmente mais simples do que há 15 anos atrás. E em mais de um aspecto diferente. Antes, além de ter um processador compatível com a placa-mãe, era preciso ter muito cuidado na hora da instalação física.

Hoje em dia os coolers, dissipadores e placas-mãe são preparados para trabalharem em conjunto, até mesmo fisicamente. As placas da AMD trazem uma base plástica, basta conectar os ganchos do dissipador e fechar a trava.

As placas da Intel são semelhantes, mas o suporte plástico geralmente fica no próprio dissipador. Basta encaixar, travar e conectar o fio do cooler à placa-mãe.

Antes, não era bem assim. Além de ser mais difícil identificar o lado correto do processador para não danificá-lo, prender o dissipador no slot era uma tarefa árdua. Geralmente era preciso forçar a trava com uma chave de fenda, até que ela encaixasse no pino plástico do soquete.

Instalar o dissipador sem trincar esse processador era uma verdadeira arte.

Instalar o dissipador sem trincar esse processador era uma verdadeira arte.

O problema disso é que a chave de fenda poderia escapar para dois lados: se fosse pra baixo, poderia raspar a placa-mãe e arrancar algumas trilhas de dados, danificando o equipamento. Do outro lado, poderia escapar e cortar a sua mão.

Se tudo isso fosse feito corretamente, ainda era preciso controlar os jumpers da placa-mãe para acertar o multiplicador e a frequência FSB para definir o clock correto da CPU. Caso você configurasse esse parâmetro errado poderia queimar o processador em menos de um segundo, pois poderia fazê-lo rodar em uma frequência diferente daquela a qual ele foi programado.

O tempo passou e esses jumpres deixaram de ser físicos, passaram para o BIOS. Até aí ainda era preciso ajustar corretamente esses parâmetros, mas a máquina já corria menos risco de problemas, já que ela detectava o modelo do processador e pré-configurava tudo.

Hoje em dia você só precisa comprar uma placa e uma CPU compatíveis e instalar tudo. Como o sistema exige zero configuração, queimar o processador por uma instalação mal feita é uma tarefa quase impossível.

Placa de vídeo

Placa de vídeo é sinônimo de máquina gamer, isso porque um desktop normal geralmente se sai muito bem com uma saída de vídeo onboard para tarefas corriqueiras. A situação muda quando os jogos entram em cena. Assim, não tem jeito é preciso uma placa offboard.

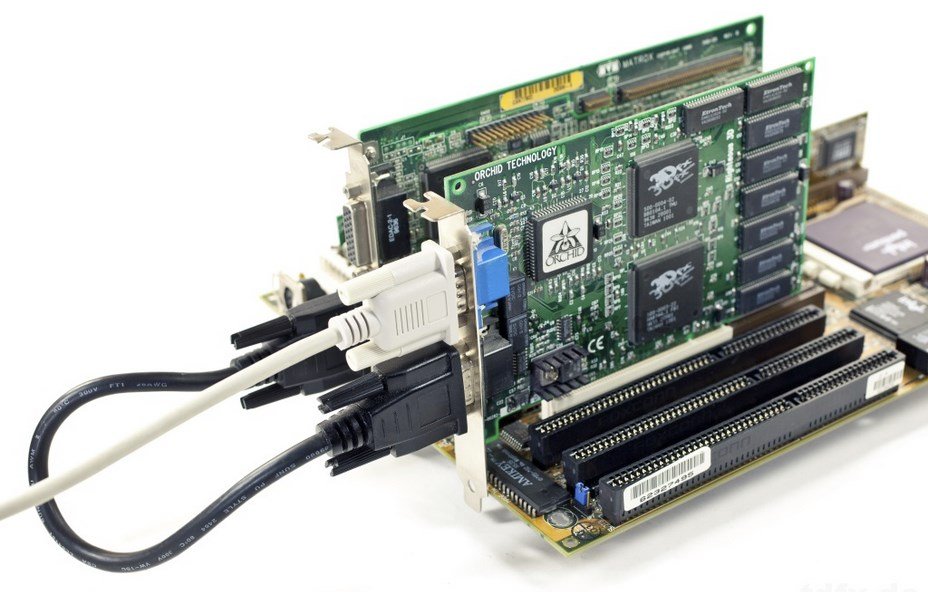

Mas você sabia que há algum tempo todas as placas eram offboard? E encaixar uma no sistema não era uma tarefa tão simples assim. Antes de tudo era preciso saber se a sua máquina comportava uma placa de vídeo ISA nova, ou quem sabe uma VESA Local Bus.

Nem mesmo as primeiras placas de vídeo 3D tornaram a vida mais fácil: a primeira geração da famosa linha Voodoo era apenas 3D. Para aceleração 2D ainda era preciso ter uma placa de vídeo externa. Um cabo exclusivo conectava a placa 3D na placa 2D comum e o monitor geralmente era ligado na segunda porta da aceleradora 3D. Complicado? E era mesmo.

Além disso, o MS-DOS ainda era uma plataforma dominante para os jogos nos PCs da época. Como a maioria dos programas rodava em “modo real”, ou seja, direto, sem passar por uma camada de sistema operacional, os jogos precisavam ter drivers específicos para funcionar. Cada um deles.

E como não existia internet, se algum jogo veio sem os drivers de vídeo, dificilmente você conseguiria ativar a aceleração gráfica. Já pensou ter uma Voodoo na sua máquina e não conseguir ativar a aceleração gráfica de Tomb Raider somente porque faltava um arquivo?

A Voodoo precisava estar conectada a uma placa de vídeo "comum" para funcionar

A Voodoo precisava estar conectada a uma placa de vídeo "comum" para funcionar

Com a chegada das placas de vídeo onboard, quase tudo ficou mais fácil. Não era mais preciso sair em busca de uma placa de vídeo compatível com o seu sistema, bastava ligar a máquina e instalar os drivers que, por sorte, vinham em um disquete ou CD que acompanhava a placa.

O único problema dessas interfaces era conectar uma placa de vídeo externa: algumas placas-mãe simplesmente se recusavam a aceitar uma placa de vídeo externa. Outras eram mais amigáveis, bastava desativar as saídas onboard no bios, desligar a máquina, e instalar a placa externa para que tudo funcionasse como deveria.

Hoje em dia não há muito segredo. Você compra uma placa nova, instala no slot PCI Express, acessa o site do fabricante e baixa os drivers. Depois disso, é só se divertir.

Placa de som

Houve um tempo em que se ter uma placa de som no computador era um artifício de luxo. Acredite se quiser: som com qualidade de CD era um opcional para quem tinha dinheiro pra investir.

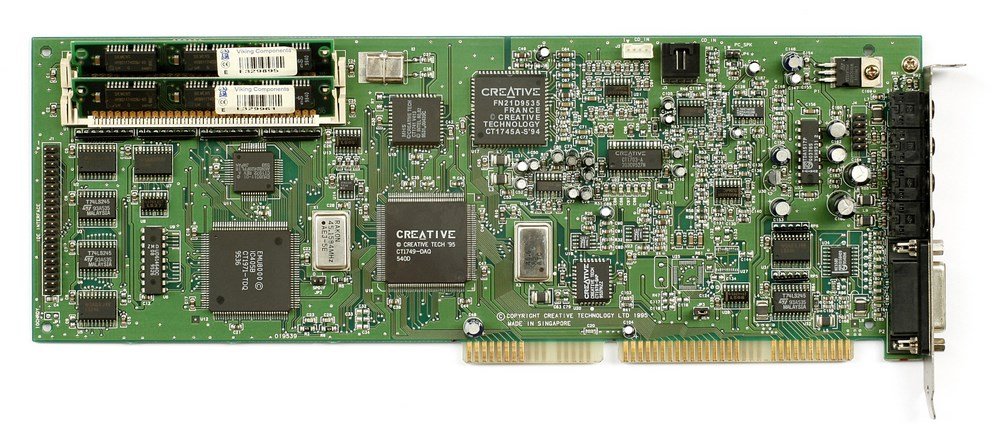

Quem conseguia adquirir um kit multimídia com uma placa de som Sound Blaster, da Creative, precisava de um pouco de conhecimento antes de conseguir fazer o sistema funcionar 100%. Isso porque não bastava instalar a placa, era preciso configurar o sistema para que ele reconhecesse o hardware na inicialização da máquina.

Encontrar um kit multimídia à venda é uma tarefa difícil hoje em dia.

Encontrar um kit multimídia à venda é uma tarefa difícil hoje em dia.

Geralmente o CD de instalação da placa fazia esse tipo de ajuste, mas quem já teve um sistema assim sabe que as regulagens “finas” precisavam ser feitos à mão, através de linhas de comando dentro do arquivo “autoexec.bat.” Veja um pequeno exemplo:

@echo off

SET SOUND=C:\PROGRA~1\CREATIVE\CTSND

SET BLASTER=A220 I5 D1 H5 P330 E620 T6

SET PATH=C:\Windows;C:\DOS

LH C:\Windows\COMMAND\MSCDEX.EXE /D:123

A terceira linha diz respeito às configurações do sistema de som, especificamente. Conhecer essas informações era necessário porque em cada aplicativo ou jogo era preciso reproduzi-las exatamente como elas podem ser vistas aqui, manualmente, um por um. Se isso não fosse feito, o jogo iria ficar sem som.

O tempo passou e os chips de som passaram para as placas-mãe, os chamados onboard. Mesmo assim, as placas de som externas não deixaram de existir, a diferença é que agora tudo fica dentro do sistema operacional, e geralmente tudo é reconhecido e instalado automaticamente, você não precisa ter trabalho algum. As interrupções e endereçamentos continuam lá, a diferença é que isso agora é feito tudo de forma transparente ao usuário.

Placa de som Creative, com interface IDE embutida.

Placa de som Creative, com interface IDE embutida.

É bem provável que você nem mesmo saiba qual é o chip de som presente na sua máquina, já que possivelmente nunca precisou fazer a instalação de drivers ou configurações mais complexas.

Armazenamento

Os SSDs já estão ganhando muita popularidade e não são mais tão incomuns. Contudo, os HDs tradicionais continuam firmes e fortes no mercado, principalmente pela sua relação custo x benefício.

Contudo, mesmo os HDs tradicionais são diferentes dos modelos mais antigos. Praticamente todas as unidades de armazenamento atuais utilizam a interface SATA, enquanto as antigas eram IDE. Mas e o que isso significa?

Além de ser um cabo de conexão diferente, o IDE tinha algumas particularidades que tornavam a sua instalação um pouco mais complicada.

Uma placa-mãe geralmente possui (ou possuía) dois conectores IDE, e cada um deles pode receber até dois periféricos. Esses periféricos devem ser organizados como MASTER ou SLAVE (mestre e escravo, em tradução livre). Essa ordem também é garantida pela posição dos cabos, sendo que uma porta IDE podia ter um SLAVE e um MASTER, não os dois ao mesmo tempo. Se isso acontecesse, o sistema não reconhecia os discos.

Mas e como configurar isso? Simples, através de jumpers (uma espécie de chave seletora). Cada um dos discos possui jumpers específicos e é só selecionar qual deles deve ser o principal e qual o secundário.

Há alguns anos todas as controladoras IDE eram externas, ou seja, era preciso instalar uma placa controladora em um slot (geralmente ISA) na placa-mãe, para então conectar o cabo IDE que ia até os HDs. Como um drive de CD-ROM também era um luxo nessa época, algumas máquinas suportavam apenas uma placa controladora, resultando em apenas uma porta IDE com suporte a dois HDs.

Conectar o drive de CD era uma tarefa para o “kit Multimídia” ou seja, a placa de som era híbrida; além de ser uma placa de som ela era também uma placa controladora IDE. Deste modo, o drive de CD era conectado à ela.

Drives de disquete também utilizavam interfaces diferenciadas, e assim como as placas IDE essas placas controladoras deviam ser instaladas separadamente. Alguns modelos eram mais poderosos e traziam conectores IDE e FDD na mesma placa.

Interface IDE: Veja a posição da trilha vermelha no cabo de dados.

Interface IDE: Veja a posição da trilha vermelha no cabo de dados.

Aos poucos, tanto IDE quanto FDD (Floppy Disk Drive) foram incorporadas à placa-mãe, facilitando a instalação de periféricos. Só que um problema ainda persistiu até o fim dos dias dessas interfaces: a posição dos cabos.

No início não haviam indicações de ordem dos cabos de dados, apenas um minúsculo número 1 ao lado da trilha 1 do conector. Esse número, com o tempo, foi substituído por uma trilha vermelha, assim, era só localizar a trilha vermelha e conectá-la ao ponto correto na placa. E se invertesse os cabos? Corria o risco de danificar os componentes; tanto a placa quanto o HDD, ou drive de disquete.

Quem montava computadores nessa época lembra do que aprendeu como regra de ouro: “No HD o fio vermelho fica do lado do conector de força” em alusão ao conector de força que vinha da fonte e ficava sempre do lado do pino 1 do conector IDE.

Para garantir que não houvessem mais erros, os conectores IDE de 80 trilhas ganharam um pino guia, que servia para acertar o lado sem erros, mas logo esse cabo foi substituído pela interface SATA, que temos até hoje.

A interface SATA facilitou muito a vida. Hoje em dia não existe muito problema para conectar as unidades de armazenamento, seja ela qual for. Basta conectar os cabos de dados, de força e pronto. Ao ligar a máquina tudo será reconhecido sem muitos problemas.

Placa-mãe

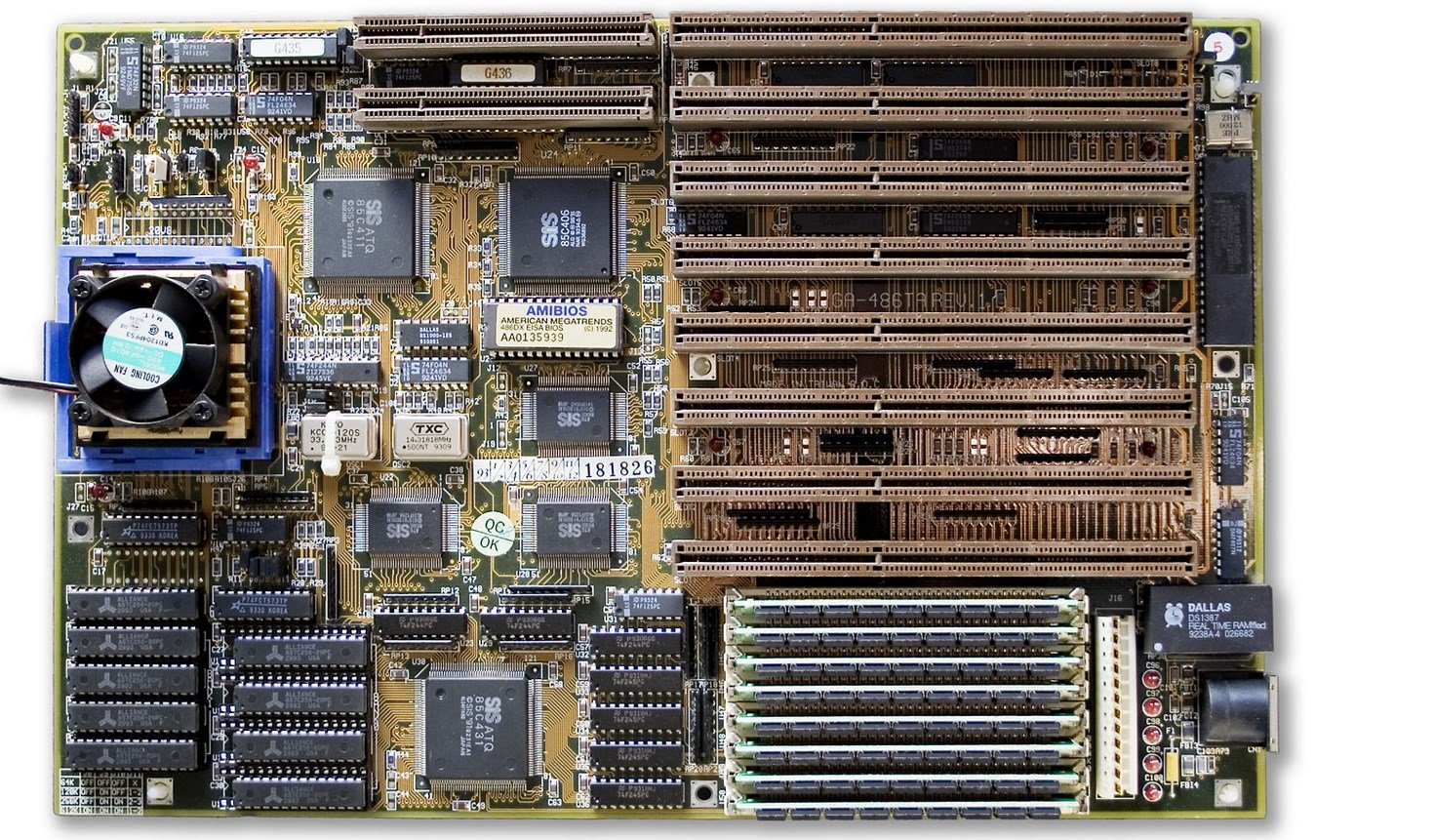

As primeiras placas-mãe eram bem simples. A grosso modo, é possível dizer que a única função delas era conectar os periféricos fisicamente, pois todos os controladores eram externos.

Os recursos mais básicos de controle passaram a ser incluídos no início dos anos de 1990, e compreendiam coisas como controle de teclado e mouse, portas seriais e, mais tarde, controladores de disquetes.

Ao instalar placas controladoras externas, era preciso ajustar a compatibilidade dos recursos e interrupções do hardware através de jumpers localizados na placa-mãe ou no BIOS. As interrupções precisavam ser independentes, por exemplo: uma placa de som não podia utilizar o IRQ 5 se o Fax-modem estivesse utilizando essa interrupção.

Configurar tudo isso exigia certa dose de conhecimento e algumas vezes dor de cabeça. Isso porque nem todas as placas externas permitiam que se alterasse parâmetros de interrupção, obrigando você a se virar como podia.

As placas-mãe já foram assim.

As placas-mãe já foram assim.

Com o passar do tempo mais componentes passaram a ser transferidos para as motherboards, como chip de vídeo, som, rede, fax-modem e muito mais. Hoje em dia é possível montar um computador sem nenhuma placa externa, já que algumas placas-mãe trazem até mesmo o processador embutido.

BIOS

O BIOS é pouco utilizado hoje em dia, principalmente porque a maioria dos componentes consegue se acertar automaticamente quando você liga o computador. Mas nem sempre foi assim.

Antes dos sistemas operacionais Plug `N Play, era preciso acertar os canais e interrupções de cada um dos itens de hardware instalados na máquina, além, é claro, de configurar cada um dos componentes precisamente. Um item fora do lugar era necessário para fazer o sistema não funcionar.

Um conflito muito comum era a porta de comunicação das portas seriais, (geralmente COM3 e COM4) que era a mesma porta utilizada pela maioria dos fax-modems. Geralmente esse conflito precisava ser resolvido no BIOS para garantir o funcionamento do sistema.

Atualizar o BIOS também era uma tarefa mais complexa. Era preciso criar um disco de boot (apenas com disquetes) e gravar os arquivos de atualização no disco. Depois era preciso reiniciar a máquina com esse sistema provisório para então atualizar o BIOS, rezando para que o disquete não apresentasse uma trilha defeituosa, pois isso poderia acabar danificando o BIOS e “matando” a placa-mãe.

Por essas e outras razões é que a atualização do BIOS da placa-mãe foi um bom tempo sinônimo de perigo, e todos que passaram por isso já ouviram a frase que devem carregar até hoje: “Se está funcionando, não atualize”.

Hoje em dia a função do BIOS mudou bastante. Além de mais complexas e cheias de recursos elas oferecem ferramentas de atualização automáticas ou via pendrive. Basta selecionar o arquivo e pronto. Algumas placas-mãe trazem mais de um arquivo de BIOS instalado, tudo para garantir a segurança do sistema.

Fax-modem, rede e jogos online

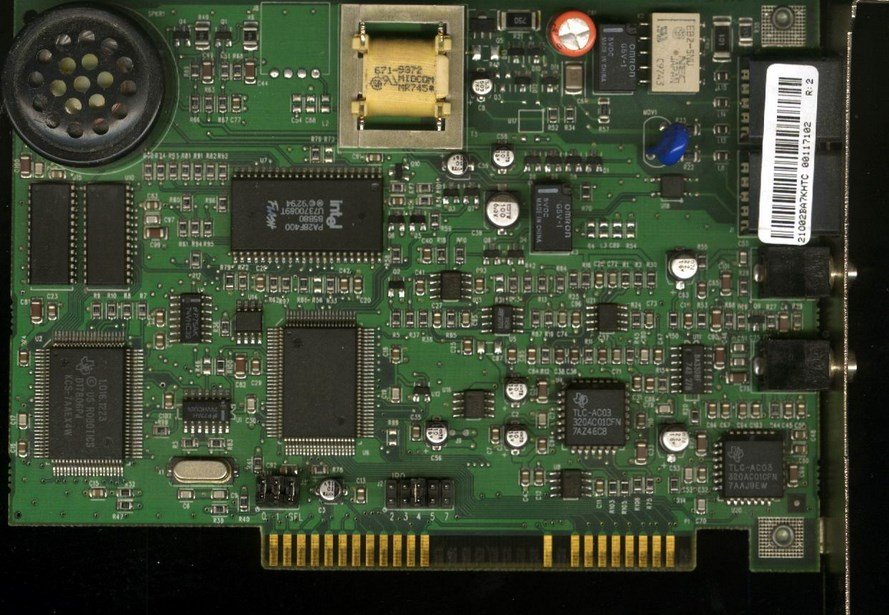

Muito tempo antes de a internet se popularizar já era possível jogar com seus amigos través de uma linha telefônica. A instalação do fax-modem era semelhante à da placa de som. Geralmente era possível controlar a porta de interrupção da placa através de um jumper físico, e depois indicar esse parâmetro dentro do arquivo autoexec.bat.

Para jogar online era preciso que o jogo tivesse suporte a esse recurso. Rodando via MS-DOS, não tinha como aproveitar a interface de conexão do sistema operacional, ou seja, era preciso literalmente configurar a máquina para receber ligações enquanto seu amigo (ou amigos) programava a máquina dele para telefonar para a sua, ou vice-versa.

Curiosamente era tranquilo jogar desse modo. A conexão era direta, logo, dificilmente havia lag entre os comandos. É claro, salvas as devidas proporções como a qualidade das linhas e a localização dos dois jogadores.

Ligar as máquinas em rede também era mais difícil, pois diversos protocolos de comunicação eram vigentes. Para fazer os computadores se entenderem era preciso combinar esses padrões.

US Robotics Sportster 56K: um mito.

US Robotics Sportster 56K: um mito.

Antes da internet existia o BBS, um sistema de comunicação bem mais primitivo que a rede mundial de computadores, mas que fez a alegria de muita gente. O BBS funcionava assim: um servidor era configurado para aceitar conexões externas, assim, os usuários precisavam discar para esse número a partir de seu computador.

Quando a conexão era estabelecida, era possível navegar pelo conteúdo desse servidor, que podia compreender salas de bate papo ou até mesmo games online.

A sigla BBS vem de Bulletin Board System, e era mais ou menos o que um website é hoje. Já imaginou ter que telefonar e estabelecer uma conexão nova para cada acesso ao TecMundo ou ao Facebook?

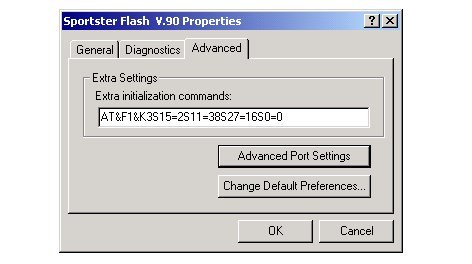

Quando a internet chegou, acessar via fax-modem era o que tinha. Isso porque era preciso fazer o modem discar para o provedor, para que esse fizesse a ponte entre a sua máquina e a web. Contudo, para que a conexão funcionasse de forma estável era preciso ajustar o hardware, e é aí que entravam vários guias especializados que traziam as “strings” perfeitas para o seu modem.

Essas strings determinavam padrões de conexão, controle de erro e padrão de transferência de fluxo de dados. E otimizar ao máximo era mais que recomendado, afinal de contas, só dava pra usar a internet depois da meia noite.

Este guia do site 3D Spotlight data do início do ano 2000, e mostra exatamente como configurar esse tipo de parâmetro. Se você é da “velha guarda” certamente vai reconhecer esses passos.

Não bastava instalar o modem, era preciso configurar tudo.

Não bastava instalar o modem, era preciso configurar tudo.

A era da banda larga chegou aos poucos. No início era preciso alugar um modem junto às operadoras, pois adquirir um separadamente era mais caro que o preço de um computador novo. Além disso, somente um técnico especializado podia configurar o sistema.

Hoje em dia a maioria das operadoras dá o modem de presente (com WiFi e tudo) para os assinantes. Além disso, ele já vem configurado e basta apenas conectá-lo ao seu computador.

Sistema operacional

Falar de todo o hardware sem passar pelo sistema operacional não parece ser justo. Vamos nos ater aos mais populares: MS-DOS e Windows, que reinaram absolutos aqui no Brasil durante o início da década de 1990.

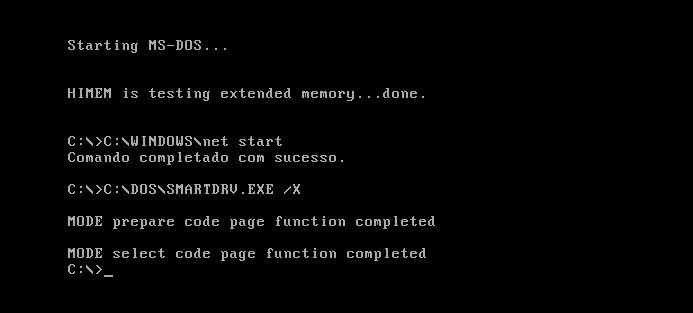

Instalar tudo no MS-DOS era bem mais complicado. Isso porque, como citamos antes, era preciso configurar quase tudo “na unha”. Poucos softwares de instalação eram capazes de fazer o trabalho direito; isso porque quando você mandava um programa configurar a placa de som, ele bagunçava outros parâmetros, como o fax-modem ou o mouse. Desse modo, era preciso ir lá no config.sys ou autoexec.bat para ajustar tudo corretamente.

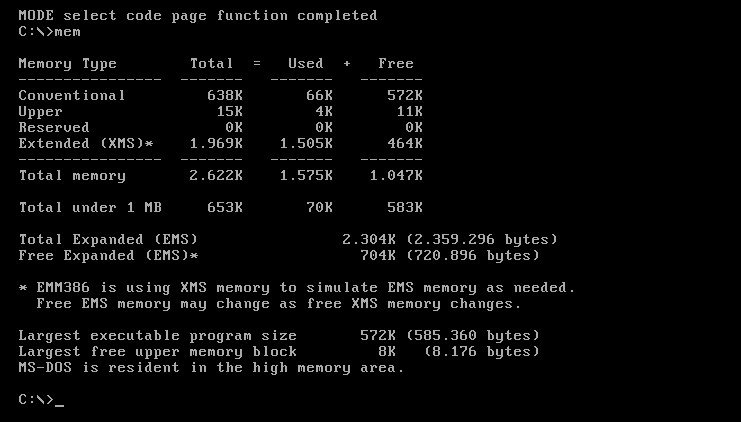

Além disso, o MS-DOS e quase todos os sistemas operacionais de sua época trabalhavam apenas com um tipo de memória: a chamada memória convencional. Isso porque os primeiros processadores IBM PC permitiam o endereçamento de apenas 1.024 Kb de memória. Desses, 394 Kb eram reservados para o sistema, o bloco UMA ou Upper Memory Área. Com isso, os programas tinham apenas 640 Kb disponíveis para uso.

Quem nunca fez piada com esta tela?

Quem nunca fez piada com esta tela?

Já pensou ter que gerenciar esses 640 Kb de memória entre placa de som, modem, portas seriais e ainda fazer os programas rodarem? Isso era uma tarefa realmente complicada, pois não adiantava ter 4 ou até 8 megas de RAM. O único jeito era alocar cada um dos parâmetros manualmente se você quisesse fazer algum programa rodar na máquina.

Para alocar os parâmetros corretamente era preciso configurar os gestores de memória estendida (como o EMM386), que podiam alocar os programas no restante da memória disponível, deixando os 640 K iniciais apenas para recursos mais importantes ou programas mais antigos e que não funcionavam com memória estendida.

A chegada dos sistema operacionais modernos mudou essa regra, permitindo que os programas pudessem alocar até 4 GB de RAM (nos sistemas 32 bits). Além disso, a memória virtual também permitiu um grande avanço na computação ao permitir que programas maiores que a quantidade de memória total pudessem ser executados.

A memória virtual é uma “RAM simulada” na unidade de armazenamento, ou seja, os dados do programa ficam na memória virtual até que precisem ser utilizados. Então, eles vão para a RAM propriamente dita.

É claro que esse sistema é mais lento que RAM real, mas possibilitou que muitos aplicativos rodassem em praticamente qualquer computador. Principalmente em uma época em que a memória RAM era incrivelmente cara. Somente pra se ter uma ideia, no início de 1995 cada MB de RAM custava aproximadamente 30 dólares. A chegada do Windows 95 e da memória virtual ajudaram muita gente a economizar uns trocados.

Gerenciar a memória era uma arte.

Gerenciar a memória era uma arte.

Hoje em dia temos sistemas operacionais bastante autônomos. O Windows 8, por exemplo, pode ser instalado praticamente sem entradas do usuário. Basta colocar o DVD (ou pendrive) e iniciar o processo. Ele dá conta de configurar quase todos os itens de hardware automaticamente.

E agora?

Montar um computador hoje em dia exige pouco conhecimento específico; no máximo um pouco de bom senso deve ser suficiente para garantir que nada saia errado. E se sair, o que menos falta na internet são guias de instalação e manutenção, inclusive aqui no TecMundo.

Somente quem pôde acompanhar de perto essa evolução sabe o quanto as coisas acabaram ficando mais fáceis hoje em dia, quando basta conectar as peças e instalar o sistema operacional, que faz praticamente tudo sozinho, desde a configuração do hardware até a instalação dos drivers e periféricos.

E essas facilidades foram muito bem vindas, pois agora passamos mais tempo utilizando a máquina do que configurando portas de comunicação e outros parâmetros. O único problema é que não é mais possível ter a mesma sensação de vitória ao ver o “micro” funcionando pela primeira vez.