Dirigir talvez não seja algo assim tão complicado. Afinal, desconsiderando-se as habilidades necessárias, essa atividade tipicamente humana pode, grosso modo, ser dividida em três dimensões. Em dado momento, um motorista deve ser capaz de: localizar-se no espaço; perceber os elementos ao redor; e colocar-se em movimento.

Além disso, conforme a indústria automobilística percebeu logo em suas primeiras décadas, um condutor que seja capaz de executar as ações listadas acima nem sequer precisa ser de carne e osso.

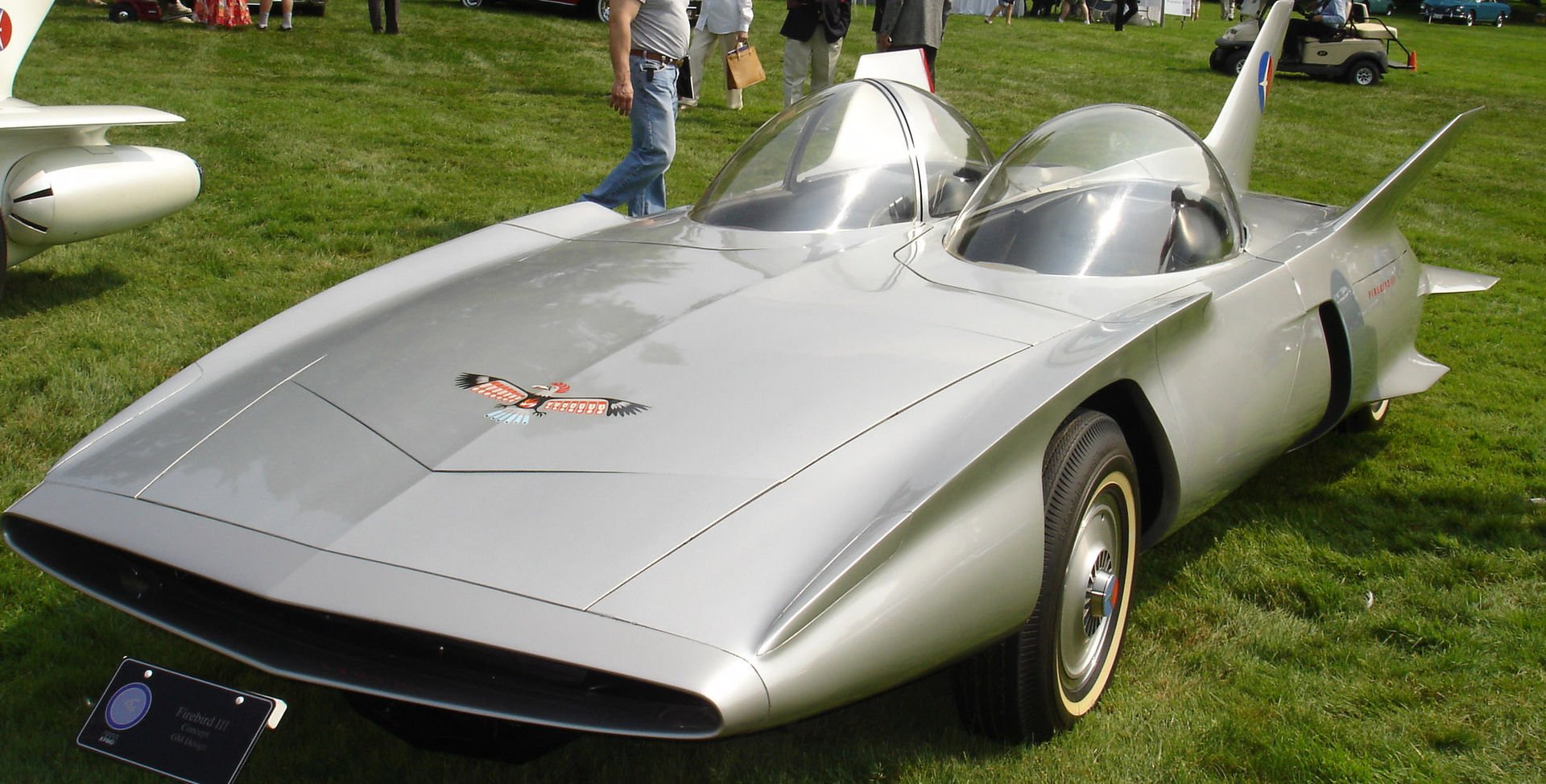

O Firebird II, da General Motors: protótipo de 1956 trazia um "cérebro eletrônico" que lhe permitia seguir por uma via sem assistência humana.

O Firebird II, da General Motors: protótipo de 1956 trazia um "cérebro eletrônico" que lhe permitia seguir por uma via sem assistência humana.

Mas aí vem a pergunta óbvia: porque nós ainda não estamos recostados tranquilamente nos assentos enquanto nossos carros se encarregam de todo o deslocamento — talvez conversando com alguém, concluindo um relatório ou simplesmente colocando a leitura em dia?

O que ocorre é que, a despeito de sensores, câmeras, algoritmos computacionais e dispositivos de localização cada vez mais sofisticados, mesmo as cabeças mais geniais (e mais bem pagas) da indústria da automação ainda tem experimentado vários desafios na hora de “ensinar” os computadores a se “localizar”, a “perceber o ambiente” e a “colocar-se em movimento”.

Ensinando o computador

No momento em que este texto é escrito, é provável que um ou vários veículos futuristas estejam rodando por conta própria pelas ruas de Mount View (completos, incluindo geringonças rotatórias sobre o teto). A Google e seus fundos praticamente ilimitados têm testado exaustivamente sistemas capazes de dar completa autonomia aos carros. E há também outros pioneiros nessa corrida, tal como o RobotCar (um Nissan Leaf elétrico), desenvolvido pelo núcleo de estudos em automação da Universidade de Oxford.

Independentemente do competidor, os desafios centrais parecem ser sempre os mesmos: como ensinar um computador de bordo a dirigir o seu veículo? E mais: como conseguir níveis aceitáveis de segurança para esse processo sem tornar o resultado tão caro que quase ninguém se animaria a comprar?

Invariavelmente, a peça vital de cada sistema de automação desenvolvido atualmente deve ser um poderoso centro computacional. Trata-se do “cérebro”, do centro nervoso que deve ser abastecido com dados, os quais utilizará para identificar padrões, reconhecer objetos na rua e definir as ações do veículo em cada caso.

Como sensores e chips “veem” o mundo

O objetivo final de qualquer sistema de automação veicular deve ser apenas um: fazer com que um carro possa se deslocar com pelo menos o mesmo nível de eficiência de um bom motorista humano. É verdade que as características mais fundamentais são facilmente recriadas em um carro, que pode perfeitamente ter um “cérebro” (computador), “olhos” (câmeras) e “ouvidos” (dispositivo para captação de áudio).

O principal obstáculo, entretanto, é fazer com que um computador seja capaz de “ver” o mundo de forma semelhante à de um ser humano. “Você pode programar um carro para dirigir simplesmente colocando nele regras de trânsito saídas de um livro”, afirmou Katelin Jabbari, uma das responsáveis pelos carros autônomos da Google, em entrevista ao site Gizmodo.

“O problema é que isso não conta para 99% das coisas que nós encontramos nas ruas”, ele continua. “Quão suavemente eu preciso frear? Com que velocidade eu deveria fazer uma curva?” Embora não seja impossível tornar chips e sensores digitais capazes de executar algo assim, a tarefa também não é nada fácil.

Localização, percepção e movimento

Já que um carro pode ganhar “cérebro”, “olhos” e “ouvidos” — na forma de computadores, câmeras e sensores —, é lógico acreditar que, em algum momento, o seu veículo possa ser capaz de se localizar, perceber o ambiente e se colocar em movimento.

Não obstante, embora a última dessas capacidades seja facilmente embutida em veículos com direção hidráulica — que podem, de fato, estacionar-se por conta própria —, os métodos para localização e percepção ainda dividem opiniões na indústria. Trata-se, afinal, de simular a forma como o cérebro humano percebe o espaço ao seu redor, o que não é pouca coisa.

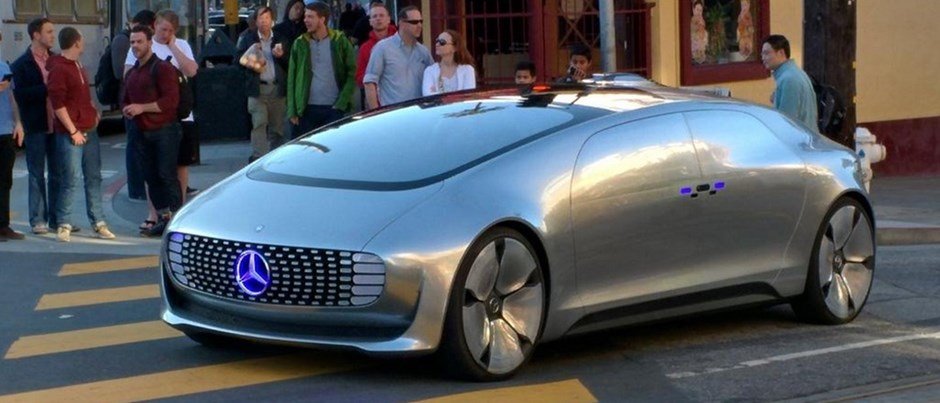

Veículo autônomo da Mercedes. O desafio é fazer com que os veículos autônomos interpretem o mundo ao redor como um motorista humano.

Veículo autônomo da Mercedes. O desafio é fazer com que os veículos autônomos interpretem o mundo ao redor como um motorista humano.

Por que não o GPS?

Quando se fala da necessidade de um sistema que permita a um carro autônomo se localizar no espaço, é comum que o GPS seja considerado como escolha óbvia. Um dos principais inconvenientes da utilização do sistema por satélites, entretanto, vem da necessidade de um céu limpo para o funcionamento adequado — o que inviabilizaria a condução autônoma em tuneis, estacionamentos fechados ou em florestas.

E há a questão da resolução. O GPS funciona com uma precisão da ordem de metros; e não é preciso ser um gênio da automação para perceber que isso jamais seria suficiente dentro de uma cidade, por exemplo. Usualmente, os dados fornecidos pelo GPS são utilizados como ponta pé inicial da navegação autônoma.

Com precisão da ordem de metros, os dados por satélites de GPS são insuficientes para que um carro autônomo se localize.

Com precisão da ordem de metros, os dados por satélites de GPS são insuficientes para que um carro autônomo se localize.

Memória vs. realidade

Apesar de o GPS não ser suficiente para informar o seu carro sobre o local específico que ele ocupa em dado momento, a maior parte dos projetos de automação atuais ainda necessitam de formas de mapeamento. Em vez de informações imprecisas de satélites, entretanto, os veículos são abastecidos com informações vindas de câmeras ou por formas especializadas de radar.

A fim de se localizar e reagir adequadamente em cada local, o sistema precisa efetuar constantemente comparações entre dados contidos em uma memória e as informações levantadas de forma imediata por meio de uma leitura do ambiente. Basicamente, há duas formas principais utilizadas atualmente para formar esses registros — cada qual com suas vantagens e desvantagens.

Emissão de laser

Em vez de utilizar o tipo de mapa que aparece no sistema de navegação do seu veículo, os protótipos atualmente desenvolvidos pela Google lançam mão de complexos mapas tridimensionais denominados prior maps (mapas prévios). Esses dados armazenados na memória são constantemente comparados com informações coletadas dos arredores por vários sensores espalhados pelo veículo.

A fim de coletar as informações ao redor, veículos como os protótipos da Google se utilizam de sistemas identificados como LIDAR (Light Detection And Ranging). Montado sobre uma estrutura giratória, esses dispositivos de detecção por laser registram 1,3 milhão de pontos em cada ciclo de forma análoga ao funcionamento de um radar (embora sem utilizar ondas de rádio) — reconhecendo objetos com a dimensão de uma TV de 14 polegadas a uma distância de até 48,8 metros.

Imagem de uma câmera estéreo sobreposta à representação em "nuvem de pontos" gerada pelo LIDAR.

Imagem de uma câmera estéreo sobreposta à representação em "nuvem de pontos" gerada pelo LIDAR.

Apesar da precisão de centímetros e da confiabilidade dos algoritmos de comparação relativamente simples do LIDAR, entretanto, o sistema é questionado pelo seu alto custo, que poderia chegar a vários milhares de dólares em uma versão comercial. Além disso, o método da Google também consome muita energia e é formado por muitas partes móveis.

Câmera digital

Em vez de geringonças giratórias sobre o veículo, os veículos autônomos em desenvolvimento na Universidade de Oxford lançam mão de algo relativamente mais simples. Trata-se de câmeras de vídeo digitais, normalmente estéreo, cuja estrutura de duas lentes simula a visão de um ser humano.

Por meio dos registros dessas câmeras, o sistema passa a identificar “pontos de interesse” ao redor — curvas, limites e outras características —, formando os chamados “patches”. Esse “patches” servem como parâmetro de comparação entre as informações obtidas pelas câmeras in loco e os dados arquivados na memória do computador.

Registros de uma câmera monocular são comparados com mapas prévios no RobotCar.

Registros de uma câmera monocular são comparados com mapas prévios no RobotCar.

O revés dessa técnica é a complexidade necessária para os algoritmos de comparação — já que comparar “pontos de interesse” é um tanto mais complexo do que identificações que levem em conta todos os pixels (como o sistema da Google). Além disso, a captação de imagens também pode ser prejudicada por condições meteorológicas adversas.

Dados prévios são mesmo necessários?

Um motorista humano normalmente é plenamente capaz de olhar ao redor e colocar um carro em movimento mesmo que não tenha a menor ideia de onde se encontra. Dessa forma, é de se perguntar: um carro autônomo realmente deveria depender de dados prévios para se locomover? Afinal, ele também poderia se locomover de forma bem razoável apenas mapeando o ambiente ao redor.

De quebra, isso ainda evitaria a necessidade de mapear extensivamente os territórios por onde poderia passar um veículo autônomo — que precisaria apenas “olhar” ao redor para saber o que fazer, seguindo faixas e obedecendo aos sinais de trânsito.

Sem dados prévios (mapas) como parâmetro, os sistemas autônomos precisariam de muito mais processamento para as leituras em "tempo real"

Sem dados prévios (mapas) como parâmetro, os sistemas autônomos precisariam de muito mais processamento para as leituras em "tempo real"

O problema, entretanto, seria a necessidade extra de processamento de dados. Sem dados prévios para comparar com as leituras sensoriais do ambiente, o computador de bordo precisaria efetuar uma quantidade muito maior de cálculos em tempo real para saber como proceder.

Dessa forma, embora a navegação imediata possa se provar como uma solução bastante natural no futuro, os especialistas apostam que a utilização de dados prévios (e as comparações entre mapas e a “realidade”) ainda devem determinar a chegada dos carros autônomos no mercado.

Percepções humanas

Embora olhar ao redor e efetuar comparações com informações prévias seja parte do que define a rotina de um ser humano na hora de dirigir, o que os pesquisadores de sistemas autônomos realmente buscam é uma máquina capaz de reagir da mesma forma que um humano. É o próprio “Santo Graal” da automação, conforme disse o professor de engenharia e especialista em processamento de imagens Sridhar Lakshmanan ao Gizmodo.

Trata-se da atenção a objetos inesperados, sejam cones de trânsito, pedestres atravessando a rua ou um carro que mude de faixa bruscamente e de outras alterações imediatas no ambiente. Além disso, é igualmente importante a interpretação do que é visto, de forma que um carro de polícia com as luzes piscando ganhe espaço na pista ou que um animal silvestre, mesmo postado ao lado da rodovia, faça o carro reduzir a velocidade, por segurança.

Kits da NVIDIA

Entre os sistemas que colaboram para dar um comportamento quase humano aos carros autônomos encontram-se os kits de processamento gráfico da NVIDIA. Embora tenham sido demonstradas a princípio com um protótipo da Audi, essas ferramentas foram posteriormente enviadas para várias fabricantes, como Bentley, Aston Martin, Tesla e Rolls Royce.

Esses kits devem ser essenciais para treinar os computadores de bordo, de forma que se tornem capazes de reconhecer objetos do mundo real. Uma vez que o treinamento seja concluído — algo que ainda deve tomar pelo menos dois anos —, o “centro nervoso” dos carros autônomos deve se tornar capaz de tomar decisões em tempo real, decidindo quando acelerar, quando freiar, quando desviar etc.

Audi e NVIDIA levaram veículo autônomo para a CES 2014

Audi e NVIDIA levaram veículo autônomo para a CES 2014

As ferramentas da NVIDIA formam duas partes distintas. Dentro dos veículos é colocado módulo com processador gráfico, devidamente embutido de um software para reconhecimento de imagens. A parte maior do kit, entretanto, foi projetada para os laboratórios de testes das fabricantes, a fim de dar origem aos primeiros protótipos.

Com entrada para até 12 câmeras simultâneas, o processador gráfico da fabricante foi projetado para quebrar as imagens capturadas em pixels. A matriz resultante é então varrida em busca de limites e padrões que sirvam para identificar partes de objetos — como as pernas de um pedestre ou um carro estacionado. O resultado então passa por testes estatísticos, a fim de concluir qual objeto é o mais provável de haver sido capturado pelas câmeras.

Uma corrida contra o tempo

Seja lá qual for o primeiro modelo de carro autônomo a chegar ao grande público, uma coisa é certa: ele precisará aprender tudo de antemão. “Você precisa ensinar o carro tudo antes de colocá-lo para rodar”, conforme frisou o diretor sênior de operações automotivas da NVIDIA, Danny Shapiro, em entrevista ao site Digits.

Será portanto uma melhor capacidade de coleta e de interpretação de dados o que definirá qual será a logomarca estampando o primeiro veículo autodirigível a chegar ao mercado. “Sistemas autônomos são tão bons quando os seus algoritmos e seus conjuntos de dados”, disse Shapiro. Enfim, ainda não se sabe qual será a marca, mas ela precisará deixá-lo completamente tranquilo, fazendo qualquer outra coisa, enquanto o conduz até o trabalho ou para casa.

Categorias

![Imagem de: Conheça o primeiro caminhão autônomo que pode circular pelos EUA [vídeo]](https://tm.ibxk.com.br/2015/05/06/06104046542209.jpg?ims=164x118)

![Imagem de: NASA está desenvolvendo seu próprio carro autônomo [vídeo]](https://tm.ibxk.com.br/2015/04/14/14092809530095.jpg?ims=164x118)